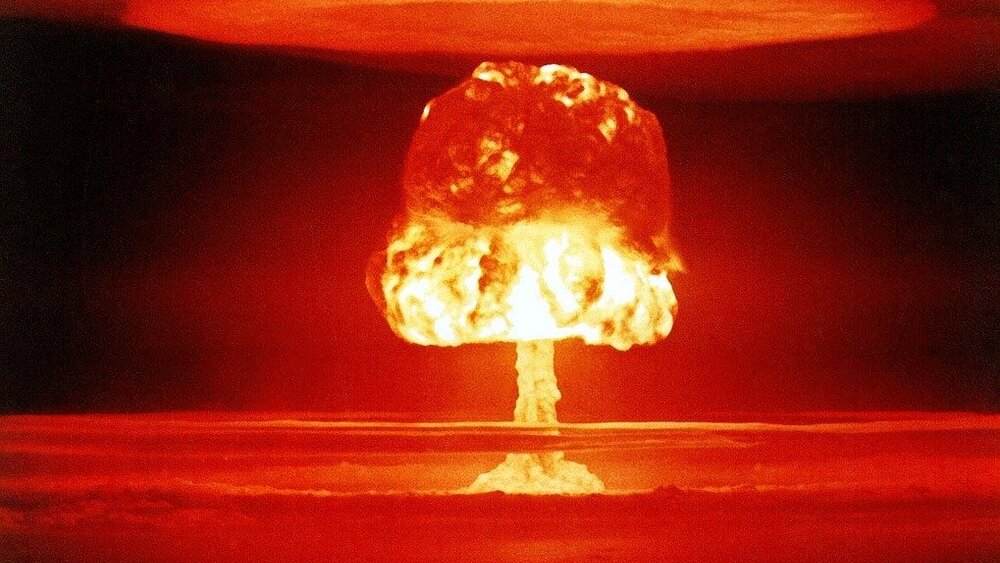

Sztuczna inteligencja kontroluje broń atomową

Będziemy spali w spokoju, bo towarzyszy nam świadomość, że nad bronią atomową czuwa dziś maszyna. Teoretycznie jest nieomylna i szansa, że popełni błąd jest znikoma. Twórcy sprzętu twierdzą, że dbają o nasze bezpieczeństwo. Od inżynierów dziś zależy nie tylko wygląd urządzenia i jego funkcjonalność, lecz również stabilność świata.

Tematykę tę podjął w Perspektywach Południowej Azji Piotr Topyczkanow w ramach opracowania „Wpływ sztucznej inteligencji na strategiczną stabilność i ryzyko jądrowe”. Dyrektor Międzynadorowego Instyturu Badawczego na Rzecz Pokoju w Sztokholmie Dan Smith uważa, że po końcu Zimnej Wojny uległy zmianie relacje międzynarodowe. Rosja pojawiła się obok Chin, co zaowocowało, że na arenie międzynarodowej nie ma już prostego układu Stany Zjednoczone kontra blok sowiecki, czy jego następca. Pomimo jednak zmian u władzy nie zniknęły arsenały jądrowe i wskutek rozwoju komputerów mają one dziś nowe znaczenie.

Topyczkanow w kwietniu 2020 wydał opracowania, które wypełnia lukę, jaki wpływ na pokój mają techniki głębokiego uczenia się, uczenia maszynowego i w ogólnym tego słowa znaczeniu sztuczna inteligencja. W Indiach oraz Pakistanie komputery przejmują z rąk ludzi ochronę i bezpieczeństwo. Scenariusze, że wskutek awarii maszyn nastąpi do konfliktu nie są już wyssanymi z palca pomysłami przemysłu filmowego. Południowa Azja wysuwa się na świecie w zakresie stosowania sztucznego umysłu do działań wojskowych. Aktywność w Indiach na tle Stanów Zjednoczonych, Rosji czy Chin wydaje się niewielka, a w Pakistanie jest nawet mniej widoczna. Jednak oba wymienione kraje traktują pracę w tym zakresie na poważnie. Jednym z elementów jaki oceniają zdaniem Topyczkanowa eksperci jest udział sztucznej inteligencji w kontroli nad arsenałem jądrowym. Póki co twierdzą, że maszyny nie wywołają wojny, a tylko zwiększą zdolności Indii oraz Pakistanu.

Wedle Maaike Verbruggena z Instytutu Studiów Europejskich na Uniwersytecie w Brukseli sztuczna inteligencja powoduje przemianę wojska. W zakresie nie związanym z bezpośrednim prowadzeniem działań bojowych w jego ocenie mają dziś decydującą rolę. Niektóre z tych elementów miały zastosowanie od dekad, zwłaszcza związane z automatycznym przetwarzaniem informacji w systemach dowodzenia i kontroli. Wskutek poprawy wydajności dziś mają one inny wymiar - większego udziału i opisanego już wielokroć ryzyko przecenienia zdolności komputera. Nie potrzebny jest komputer z możliwością odpalania rakiet z ładunkami jądrowymi, aby wywołał konflikt na tym polu. Sztuczny umysł wdziera się w coraz to inne, pokrewne dziedziny, co tworzy sieci współzależne od urządzeń oraz ich osądu. Francja, Wielka Brytania oraz Stany Zjednoczone opracowują trzecia generacje łodzi podwodnych o napędzie atomowym. W dwudziestej dekadzie XXI wieku Dreadnought wejdzie do służby, a dekadę później Columbia. Sztuczna inteligencja ma na nich kluczową rolę w nawigacji oraz przeciwdziałaniu wykryciu. Wykrywanie, precyzja, szybkość, tworzenie fałszywek na użytek propagandy, a także dostęp do wcześniej nieosiągalnych dla walk rejonów łączą się z maszynami.

Z kolei Kritika Roy, badacz IDSA z New Dehli, wskazuje, że od 2018 roku Indie wprowadzają sztuczną inteligencję do armii jako jeden z celów strategicznych dla kraju. Obok tego rząd wprowadził go do farmacji w ramach badań nad obronią przed bronią biologiczną. Armia stosuje sztuczny mózg między innymi jako element rozpoznania. Roy wskazuje, że takie posunięcia mają na celu w pierwszej kolejności ograniczenie liczby ludzi oraz zmniejszenie ich roli. Zarazem jako legendę przedstawia się historię oficera sowieckiego Stanisława Petrowa. Zignorował on fałszywy alarm o ataku jądrowym na ZSRS w 1983.

Dla celów strategicznych sztuczna inteligencja ułatwia ich klasyfikacje i przewidywania. Nie tylko z resztą w armii, bo przykładowo już część maszyn prowadzi skupy i sprzedaże na giełdzie, bo dokonuje tego z szybkością do milisekund. Dla Indii w ramach Multi-Agent Robotics Framework (MARF) trwają w armii prace nad chodzącym po ścianach Wall Climber i projektem Snake z przeznaczeniem do zwiadu, bo on przekłada się na bezpośredni potencjał armii. Dimitrij Stefenowicz wskazuje, że dla przykładu w Rosji trwają pracę nad samomyślącą bronią, czego przykładem są manewry wykonywane przez hipersoniczne rakiety Awangarda.

Problem ze sztuczną inteligencją sprowadza się do faktu, że dążenia Pakistanu, Chin oraz Indii do włączenia ich do arsenałów przy broni jądrowej czyni zdaniem Topyczkanowa sytuację ciężką do przewidzenia. Inny analityk Saman Aman Sial z CISS sądzi, że wprowadzenie takich rozwiązań w Pakistanie nie ustabilizuje regionu, ale wręcz będzie generowało konflikty. Tym samym wprowadzenie maszyn w miejsce człowieka w tym aspekcie grozi kolejnymi konfliktami.

Jacek Skrzypacz

Źródło: Jacek Skrzypacz